robots.txt چیست؟

فایل robots.txt مجموعه ای از دستورالعمل ها برای ربات ها است. این فایل در فایل های منبع اکثر وب سایت ها قرار دارد. فایلهای Robots.txt بیشتر برای مدیریت فعالیتهای رباتهای خوب مانند خزندههای وب در نظر گرفته شدهاند، زیرا رباتهای بد احتمالاً دستورالعملها را دنبال نمیکنند.

یک فایل robots.txt را مانند یک علامت «مشخصات رفتاری» در نظر بگیرید که روی دیوار یک باشگاه ورزشی، یک بار یا یک مرکز اجتماعی نصب شده است: این علامت به خودی خود قدرتی برای اجرای قوانین ذکر شده ندارد، اما مشتریان «خوب» هستند. قوانین را رعایت خواهند کرد، در حالی که مشتریان “بد” احتمالا آنها را زیر پا می گذارند و خود را از انجام ان ها باز می دارند.

درواقع ربات یک برنامه کامپیوتری خودکار است که با وب سایت ها و برنامه ها تعامل دارد. ربات های خوب و ربات های بد وجود دارند و یک نوع ربات خوب، ربات خزنده وب نامیده می شود. این رباتها صفحات وب را «خزیدن» میکنند و محتوا را فهرست بندی میکنند تا بتواند در نتایج موتورهای جستجو نشان داده شود.

یک فایل robots.txt به مدیریت فعالیتهای این خزندههای وب کمک میکند تا بر سرور وب میزبان وبسایت مالیات اضافه نکنند، یا صفحاتی را که برای نمایش عمومی نیستند فهرستبندی کنند.

فایل robots.txt فقط یک فایل متنی بدون کد نشانه گذاری HTML است (از این رو پسوند txt. دارد). فایل robots.txt مانند هر فایل دیگری در وب سایت بر روی وب سرور میزبانی می شود. در واقع، فایل robots.txt برای هر وبسایت معین را میتوان با تایپ URL کامل برای صفحه اصلی و سپس افزودن /robots.txt، مانند https://www.cloudflare.com/robots.txt، معمولاً مشاهده کرد.

این فایل به جای دیگری در سایت لینک داده نشده است، بنابراین کاربران به احتمال زیاد به آن برخورد نمی کنند، اما اکثر ربات های خزنده وب ابتدا قبل از کراول کردن بقیه سایت، به دنبال این فایل می گردند.

فایل robots.txt چگونه کار می کند؟

در حالی که یک فایل robots.txt دستورالعمل هایی را برای ربات ها ارائه می دهد، در واقع نمی تواند دستورالعمل ها را اجرا کند. یک ربات خوب، مانند یک خزنده وب یا یک ربات فید خبری، سعی می کند قبل از مشاهده هر صفحه دیگری در یک دامنه، ابتدا از فایل robots.txt بازدید کند و دستورالعمل ها را دنبال کند. یک ربات بد یا فایل robots.txt را نادیده می گیرد یا آن را پردازش می کند تا صفحات وب ممنوعه را پیدا کند.

یک ربات خزنده وب از خاص ترین مجموعه دستورالعمل ها در فایل robots.txt پیروی می کند. اگر دستورات متناقضی در فایل وجود داشته باشد، ربات از دستور granular تر پیروی می کند.

نکته مهمی که باید به آن توجه داشت این است که همه زیر دامنه ها به فایل robots.txt خود نیاز دارند. به عنوان مثال، در حالی که www.cloudflare.com فایل مخصوص به خود را دارد، همه زیر دامنه های Cloudflare (blog.cloudflare.com، community.cloudflare.com و غیره) نیز به فایل خود نیاز دارند.

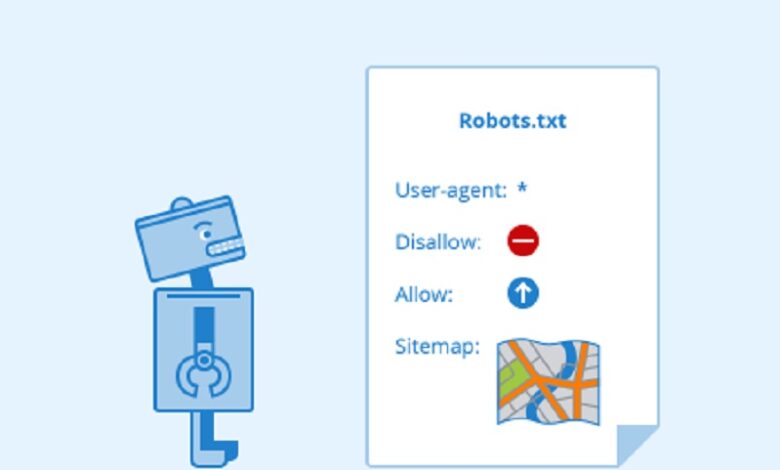

چه پروتکل هایی در فایل robots.txt استفاده می شود؟

در شبکه، پروتکل قالبی برای ارائه دستورالعمل ها یا دستورات است. فایل های Robots.txt از چند پروتکل مختلف استفاده می کنند. پروتکل اصلی Robots Exclusion Protocol نام دارد. این موضوع راهی است برای اینکه به ربات ها بگویید از کدام صفحات وب و منابع اجتناب کنند. دستورالعمل های فرمت شده برای این پروتکل در فایل robots.txt گنجانده شده است.

پروتکل دیگری که برای فایل های robots.txt استفاده می شود، پروتکل Sitemaps است. این را می توان یک پروتکل گنجاندن ربات ها در نظر گرفت. نقشههای سایت به خزنده وب نشان میدهند که در کدام صفحات میتوانند بخزند. این کمک می کند تا اطمینان حاصل شود که یک ربات خزنده هیچ صفحه مهمی را از دست نخواهد داد.